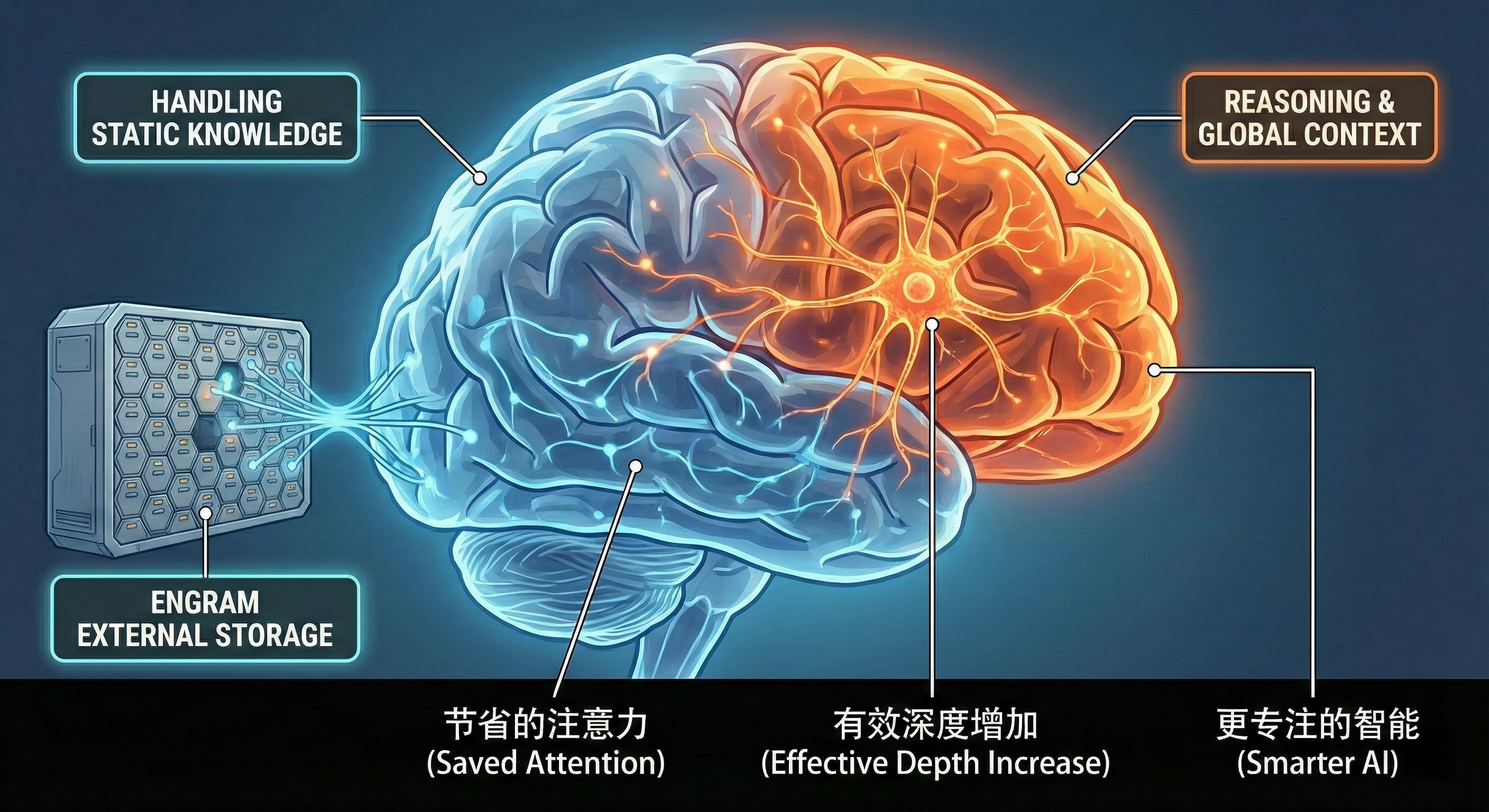

DeepSeek V4 Engram

Engram 这个词本身含义是 “记忆痕迹” ,当我们要记住某件事时,脑细胞(神经元)之间会形成一种特定的物理连接或化学变化,这个留下的“痕迹”就叫 Engram。

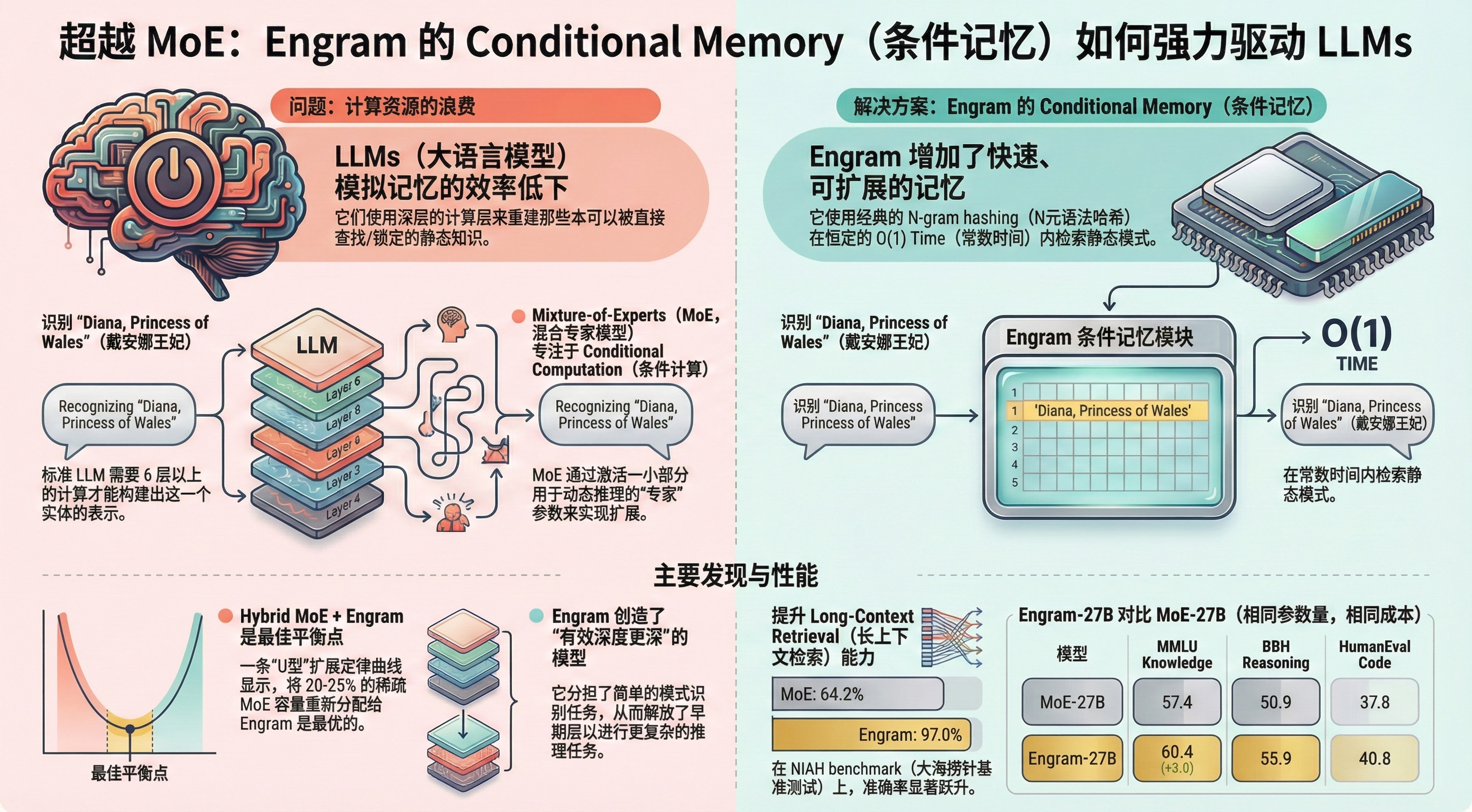

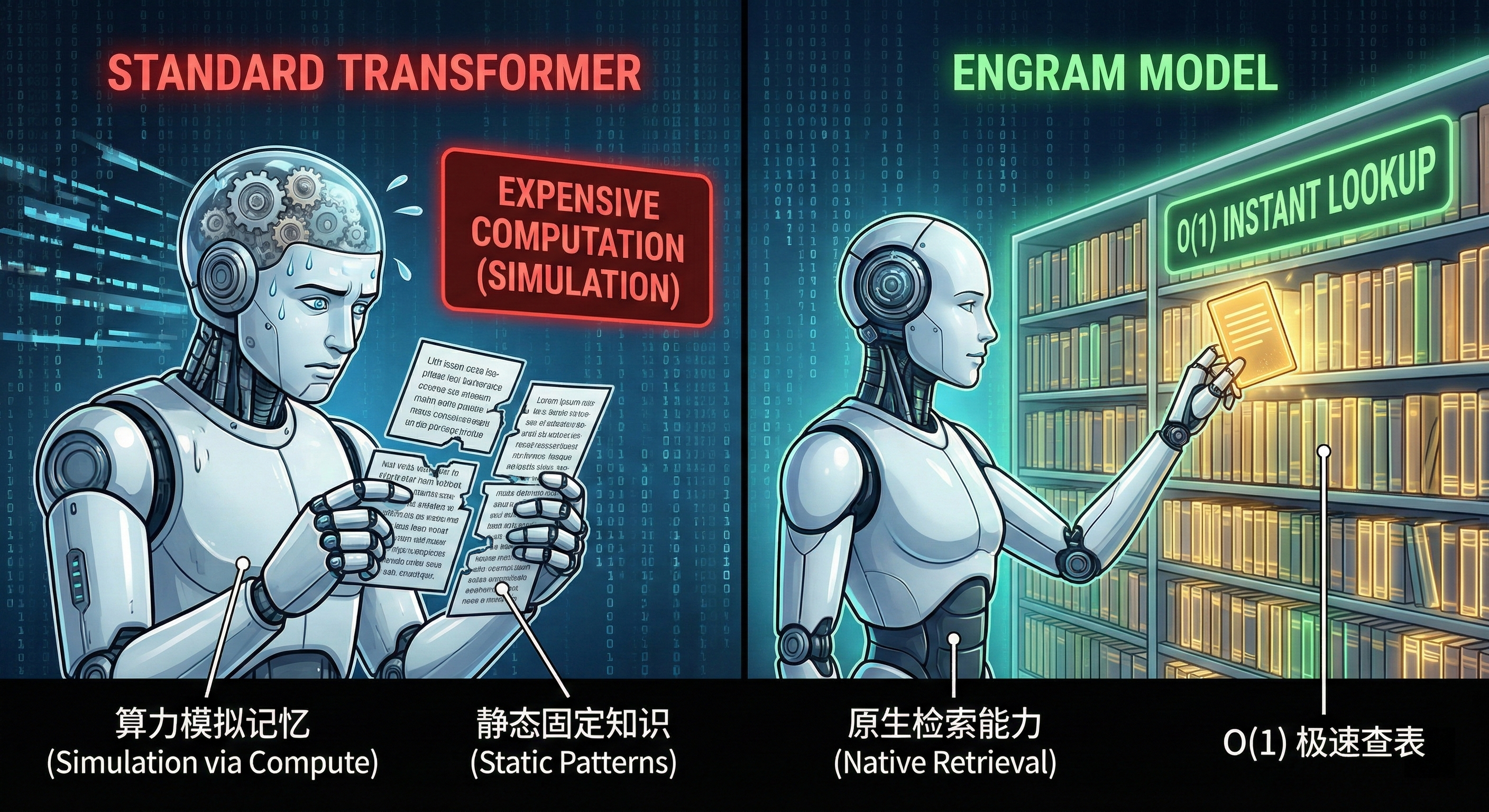

在 DeepSeek 这篇 论文 中,Deepseek 实现了类似这个过程的一种机制。它们利用 N-gram (N 元语法) 将文本切割成各种长度的片段,然后通过哈希函数映射到一张巨大表中,这样当 AI 进行一些固定的常用的词时,就不用像以前那样一个 token 一个 token 的拼出来去识别,而直接通过查询这个哈希表来得到它的含义。这个表就像 Engram 一样,在特定神经元之间留下特定的变化。

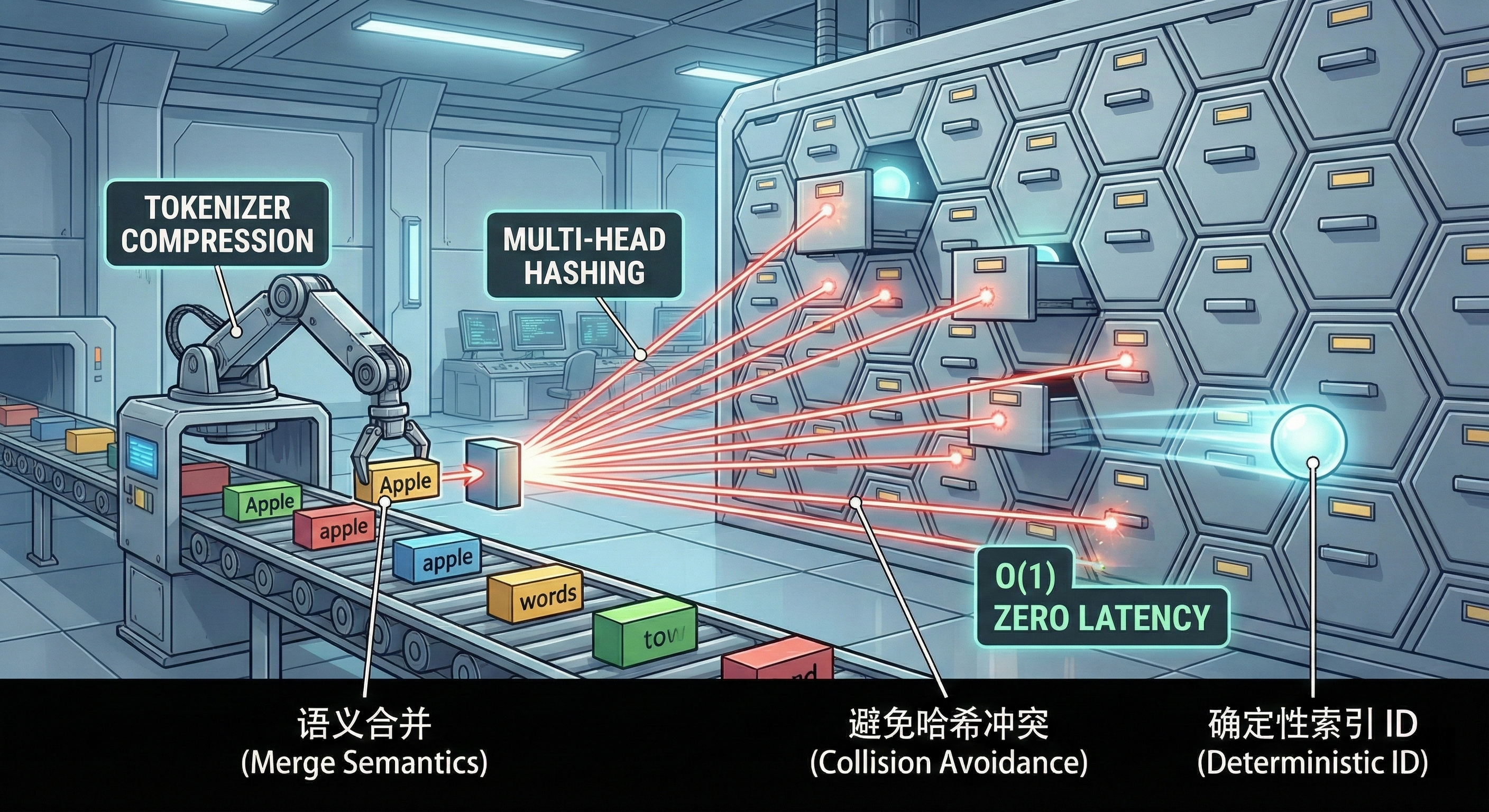

hash 冲突。这是 hash 算法决定的,Apple 和 Banana 可能会命中同一个 hash,解决办法是多构建几张 hash 表(多头 Hash,作者用了 K 个不同的哈希头,每次查不同的 hash 表,最后后把这就 K 个地方查出来的向量拼在一起,组成这个词的最终记忆)一般不会在多个表中产生完全相同的冲突。

- Token 会很多。为了让字典更紧凑,它先把那些意思一样但写法不一样的词(比如 "Apple" 和 " apple")合并成同一个 ID,这叫 Tokenizer Compression,能节省约 23% 的空间。

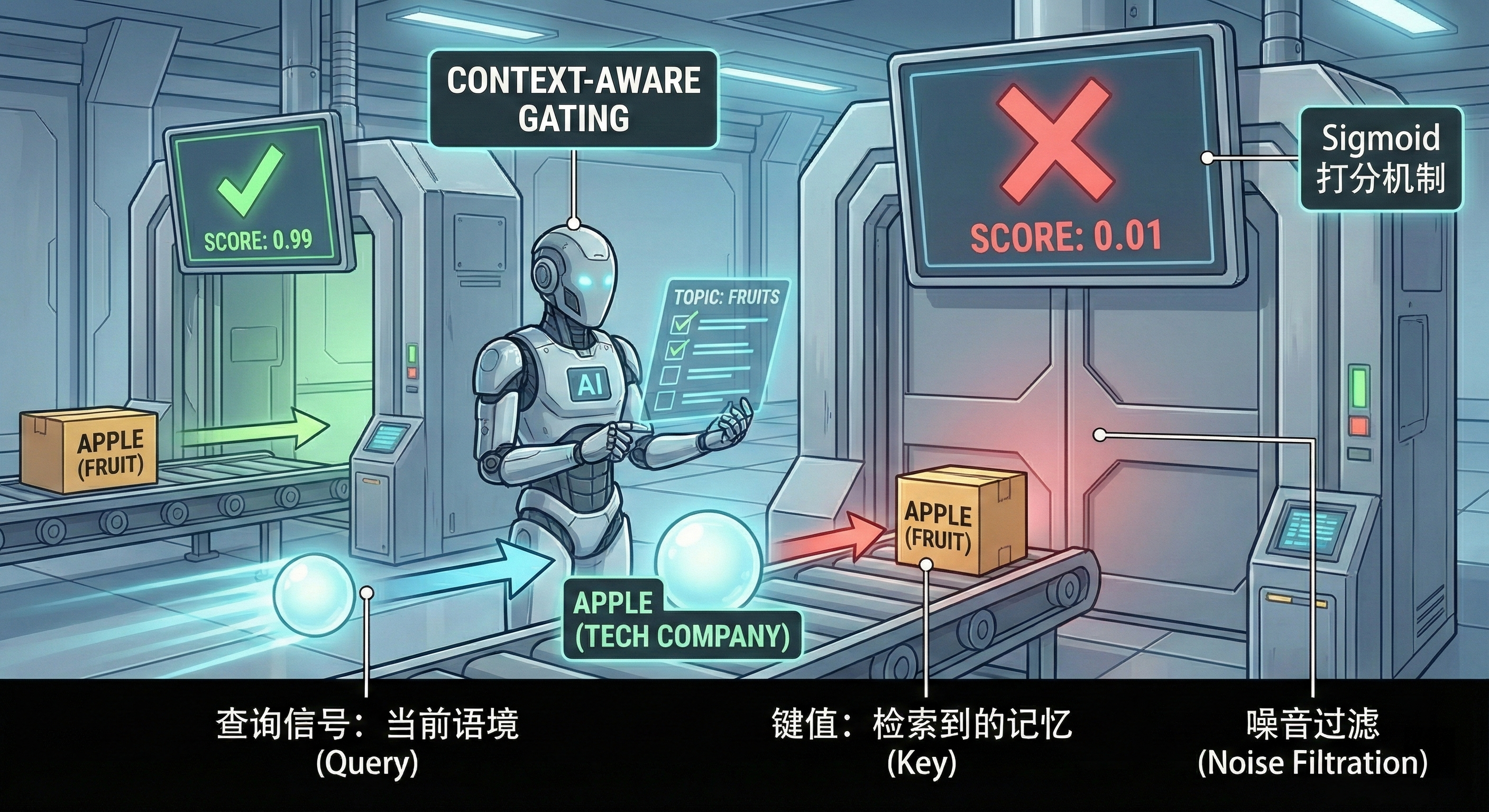

- 表中的记忆可能是错误的。因为查表是“死”的,可能会查错(哈希冲突)或者查到不合时宜的东西(语境不对)。这里通过一个 门控机制(Gating Mechanism) 来判断:

- 对比信号

- Query (查询信号):机器人当前大脑在思考的内容(也就是当前的隐藏状态 Hidden State ht),这包含了上下文理解

- Key (字典索引):查出来的那个记忆 et

- 打分: 门控机制计算这两者的相似度。

- 如果是“我要去北京”,查出“北京”是“中国首都”,上下文吻合,门打开(分数接近 1),把记忆放进来。

- 如果是“哈希冲突”查出了个无关的词,或者语境不符,上下文不吻合,门关上(分数接近 0),直接忽略这个记忆。

- 对比信号